Cyber Security - Müssen IT-Landschaft und Design von computergestützten Systemen überdacht werden?

Seit den letzten Jahren stellt Ransomware eine ernst zu nehmende und schlecht bewältigte Bedrohung sowohl für Firmen als auch für Privatpersonen dar. Die jüngsten Ereignisse mit "WannaCry" haben gezeigt, wie real eine solche Bedrohung sein kann, auch wenn diese erste weltweite Attacke¹ aufgrund von einigen "Designfehlern" der Malware nur eine begrenzte Auswirkung hatte. Wir sollten uns aber bewusst sein, dass sich die Situation noch verschlechtern kann.

Jenseits des besonderen "WannaCry"-Falls sollte die jetzige Situation der industriellen IT Landschaft, insbesondere für computergestützte Anlagen wie z.B. Labor-, Produktions- und Infrastrukturanlagen, ernsthaft überdacht werden. Die vorsätzliche Absicht, Systeme, Infrastruktur, Daten und Unternehmen zu zerstören, sollte vielmehr eingestanden statt unterschätzt bzw. ignoriert werden.

Wenn man Diskussionsforen anschaut, lautet die Aussage der meisten Kommentare bezogen auf "WannaCry", dass diese Attacken nur möglich sind, weil Systemadministratoren faul und Unternehmen knausrig sind und nicht in Software-Updates investieren. Selbst wenn diese Aussagen in manchen Fällen zum Teil richtig sein mögen, ist die Situation - insbesondere für die regulierte Pharmaindustrie und deren GxP-Umfeld - weitaus komplizierter.

Update-Management

WannaCry betraf als erstes "veraltete" und nicht aktualisierte Betriebssysteme². Und die Hauptursache für den Einsatz von veralteten Betriebssystemen ist die Schwierigkeit von Software-Updates für Produktionsanlagen und Analysegeräte steuernde computergestützte Systeme. Dabei geht es in erster Linie nicht um den Requalifizierungs- bzw. Revalidierungsaufwand, sondern um die vielseitigen Kompatibilitätsprobleme zwischen Anwendungen und Betriebssystem-Updates.

Seit Anfang der 1990er Jahre hat Microsoft die Nutzung von Windows® nicht nur für Bürozwecke, sondern auch als eine geeignete Automatisierungsplattform für Industrie- und Prozessanlagen beworben. Unterschiedliche Frameworks und Dienste wurden bereitgestellt, um die Implementierung von Steuerungsfunktionalitäten zu unterstützen.

Standardmäßig implementiert seit Windows® NT4, bietet DCOM - Distributed Component Object Model - ein Kommunikationsframework, das die Applikation- Server-Infrastruktur unterstützt. So ein Framework unterstützt unter anderem die Implementierung von OPC - OLE³ für die Prozesssteuerung - die für Prozessautomatisierungszwecke genutzt wird. Allerdings hat die "Lovsan"- Wurm-Kontaminierung im Sommer 2003 schon die Anfälligkeit von Prozessleitsystemen gezeigt, die auf DCOM angewiesen sind. Die Installation eines Betriebssystem-Patches, das einfach nur Kommunikationsports stillgelegt hat, um die Ausbreitung des "Lovsan"-Wurms zu begrenzen, verursachte Funktionsstörungen bei Automationssystemen. Ausgerechnet diese Ports wurden von DCOM benutzt.

Die unvorsichtige Anwendung des Windows® XP Service Pack 2 auf PCs, die Laborgeräte steuern, verursachte mehrfach ernste Betriebsstörungen im Labor-Umfeld. Die Industrie und ihre Gerätelieferanten mussten lernen, dass Betriebssystem-Patches und Service-Packs Prozessleitsysteme sowie Laborgeräte unbrauchbar machen können.

Solche Fälle haben dazu geführt, dass Anlagen- und Gerätelieferanten nur sehr beschränkt Betriebssystem- Updates unterstützt haben. Leider gilt das ebenfalls für die Virtualisierung von Applikationen, die Anlagen steuern. Darüber hinaus führt der berechtigte Wunsch, den Support mitsamt Kosten zu minimieren, allzu häufig dazu, dass teures Equipment softwareseitig nach einigen Jahren nicht mehr unterstützt wird. Selbst wenn Hardware und Mechanik - einschließlich Ersatzteilen - immer noch unterstützt werden, werden Betriebssystem- und Steuerungssoftware-Updates erheblich eingeschränkt. Die Industrie ist mit der Situation konfrontiert, dass teure Ausrüstung, die eigentlich eine Investition für ein oder zwei Jahrzehnte darstellen sollte, nach wenigen Jahren nur noch mit einer veralteten Softwarekonfiguration bedient werden kann.

Die geringe Reife von Windows® -Betriebssystemen seit der Erscheinung von VistaTM sowie häufig wechselnde Betriebssystemarchitekturen und Schnittstellendesigns verursachen deutliche Entwicklungs- und Update-Kosten für die Lieferanten von computergestützten Geräten und von Automationsanwendungen. Diese Situation erklärt (ohne es zu rechtfertigen), warum die Industrie Windows® XP so viele Jahre treu geblieben ist, nachdem Microsoft angekündigt hatte, dessen Unterstützung einzustellen. Auf der anderen Seite ist die Versuchung für Gerätelieferanten groß, die zusätzlichen Entwicklungskosten teilweise mit dem Verkauf neuer Ausrüstung zu decken, anstatt bestehende Anlagen und Geräte weiter mit Software-Updates zu unterstützen.

Diese Beschreibung soll schlechte Geschäftspraktiken nicht rechtfertigen, sondern versucht vielmehr, die aktuelle Lage zu erklären.

IT-Infrastrukturdesign: Robustheit oder schlechte Praktiken

Es gibt viele Gründe, gute IT-Infrastruktur- und Netzwerk- Design-Praktiken anzuwenden, um sowohl die Zuverlässigkeit und die Robustheit der IT-Infrastruktur zu gewährleisten als auch die Informationssicherheit zu verbessern, zum Beispiel:- Netzwerksegregation

- Aufbau von getrennten Netzwerken für die Büro-, Labor- und Prozessautomations Prozessautomations- Umgebungen sowie die Verwaltung der IT-Infrastruktur - Widerstandsfähige Sicherheitskonzepte, die einen starken Schutz und die "Verkapselung " der verschiedenen Betriebsumgebungen gewährleisten

- Zum Beispiel durch den Einsatz von internen Firewalls zwischen den Labornetzwerken bzw. den Automationsnetzwerken und dem Rest der IT-Infrastruktur.

Heute stellen solche Gestaltungsmaßnahmen keine zusätzliche Hardware- und Softwarekosten dar. Zuerst erfordert die Implementierung von solchen Maßnahmen verfügbare Fachkompetenz sowie die Erarbeitung von robusten IT-Infrastrukturen und IT-Sicherheitskonzepten. Zusätzlich zu einem robusten IT-Infrastrukturdesign müssen gute IT-Betriebspraktiken implementiert werden, zum Beispiel:

Aktive Netzwerk- und Betriebsüberwachung

- Zahlreiche (Open Source sowie kommerzielle) Überwachungslösungen sind verfügbar und ermöglichen eine aktive und zuverlässige Überwachung von Netzwerk- und IT-Infrastruktur-Betrieb. Heutzutage gibt es keine Entschuldigung mehr dafür, den IT-Betrieb nicht aktiv zu überwachen - einschließlich einer aktiven Alarmierung bei Störungen.

- Die Überwachung liefert nicht nur ein aktuelles Bild der IT-Infrastruktur-Komponenten und -Netzwerke. Sie ermöglicht auf Basis historischer Daten auch den Vergleich zwischen der aktuellen Situation und der vorherigen Konfiguration. Genauso können anhand eines genauen Konfigurationsmanagements mögliche Abweichungen und deren durch Updates und Änderungen bedingte Ursachen erkannt werden.

- Zuverlässige (und paranoide) Datenmanagement- Strategie

- Viren und Ransomware können die Integrität von gesicherten Daten einfach gefährden, wenn diese nicht ausreichend geschützt sind. Es ist nicht akzeptabel, dass Partitionen, die für Datensicherungszwecke verwendet werden, ständig zugreifbar bleiben. Wenn Benutzer oder Systeme, die Zugang auf solche Sicherungsdaten haben, kontaminiert werden, wird die Ransomware ebenfalls Zugriff auf die gesicherten Daten haben. Es muss mindestens sichergestellt werden, dass die Partitionen, die für Datensicherungszwecke verwendet werden, nach der Durchführung der Sicherungsvorgänge getrennt werden und somit nicht zugreifbar sind. Besser wäre, eine zentrale Backup-Applikation für die Durchführung von Sicherungsaktivitäten einzusetzen und die gesicherten Daten in einem für diesen Zweck dedizierten Teil der IT-Infrastruktur mit eingeschränktem Zugang abzulegen (z.B. über ein dediziertes Backup-Netzwerk, das nur für die zentralen Backup-Server zugänglich ist). Die Virtualisierung ermöglicht ebenfalls die Implementierung von robusten Backupkonzepten auf Hypervisor- Ebene, die sich nur sehr wenig auf die Leistung laufender virtueller Maschinen auswirken.

- Aufgrund der Kritikalität der heutigen Situation müssen angemessene und abwehrende Backupstrategien sowohl ausgearbeitet und implementiert als auch regelmäßig geprüft, geschult und geübt werden. Grundsätzlich sollte ein inkrementelles Backupverfahren nur für kurzfristige Zwecke (weniger als 24 Stunden) eingesetzt werden. Für tägliche Sicherungen sollte mindestens ein differenzielles Backupverfahren bevorzugt werden. Vollständige Sicherungen (full Backups) müssen regelmäßig ausgeführt werden, um eine zuverlässige "Daten-Baseline" zu erstellen, die im Falle einer Katastrophe eine schnelle und zuverlässige Datenrekonstruktion ermöglicht. Schließlich ist die kritische Frage: "Wie viele Daten kann ich mir leisten zu verlieren?" Die Antwort darauf wird das RPO (Recovery Point Objective) festlegen.

- Die notwendige Wiederherstellungszeit (RTO: Recovery Time Objective) sollte nicht unterschätzt werden! Selbst wenn es möglich ist, regelmäßig sehr große Datensätze zu sichern, benötigen die derzeit verfügbaren technischen Mittel Zeit für die Wiederherstellung von umfangreichen Datensammlungen. Je nach verwendeten Backup-Strategien kann die Datenwiederherstellung mehrere Tage (sogar Wochen) in Anspruch nehmen - selbst bei einer leistungsstarken IT-Infrastruktur. Die Datenwiederherstellung - Maßnahmen, Verfahren - muss regelmäßig geübt und deren Leistung kontrolliert werden.

Diese Maßnahmen erheben weder Anspruch auf Ausführlichkeit noch auf Vollständigkeit. Das IT-Infrastruktur- Design und die Bestimmung von IT-Betriebsprozessen müssen auf Grund von genauen (und echten) identifizierten Risiken erarbeitet werden.

Verbesserungsvorschläge

Welche operative Plattform für Industrie- und Prozesssteuerungsanwendungen?

Ist Windows® ein zuverlässiges Betriebssystem für Prozesssteuerungszwecke?

Auch wenn Windows® XP definitiv ein altes - wenn auch zuverlässiges - Betriebssystem ist, ist es interessant, auf die letzten 24 Monate zurückzublicken.

Seit Windows® XP hat Microsoft vielfache Architekturund Schnittstellenwechsel vorgenommen, was die Rückwärtskompatibilität von Anwendungen eingeschränkt und die Entwicklungsinvestition von Softwareanbietern gefährdet hat. Ebenfalls wurden neue Betriebssystemplattformen eingeführt und später eingestellt.

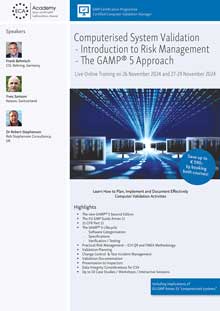

Seminarempfehlung

Tuesday, 25 November 2025 9 .00 - 18.00 h

Computerised System Validation: Introduction to Risk Management - Live Online Training

Zudem versucht Microsoft, die Einführung von neuesten Betriebssystemen mit fragwürdigen und aufdringlichen Mitteln durchzusetzen4, was die Integrität von bestehenden Systemen gefährdet und die IT-Infrastrukturen von Kunden überlastet. Gleichzeitig haben Betriebssystem-Updateprozesse zahlreiche Systemabstürze verursacht und den Kontrollaufwand - insbesondere für die Begrenzung und Beherrschung des Update- Umfangs - dramatisch erhöht.

Das Ergebnis von solchen aggressiven "Durchsetzungspraktiken" ist, dass die Systemadministratoren mehr beschäftigt waren, den täglichen IT-Betrieb zu retten und gegen Datenschutzprobleme zu kämpfen als prospektive Verfahren zu implementieren, um Anwendungen zur nächsten Betriebsplattform zu migrieren.

Mit dem "Patch Tuesday" vom 11. April 2017 - nur einige Wochen vor der "WannaCry"-Attacke - hat Microsoft bestätigt5, dass das Einspielen von Windows® 7-Sicherheitspatches nicht mehr auf Systemen möglich sein wird, die die neuesten Mikroprozessor-Architekturen - AMD Zen bzw. Intel Kaby Lake - verwenden, auch wenn dieses Betriebssystem noch bis April 2020 unterstützt werden soll. Dieses Verhalten wurde schon im Sommer 20166 angekündigt. An dieser Stelle sollte erwähnt werden, dass es keine technischen Gründe für eine solche Einschränkung gibt; diese Einschränkung erfüllt ausschließlich ein Marketingziel: den Marktanteil von Windows® 10 zu steigern. Wenn Microsoft diese Strategie in Zukunft fortsetzt, werden die auf Windows® 7 basierenden Systeme schon bald die "neuen XP-Systeme" werden, was Ersatzsysteme, die auf den neuesten Mikroprozessor- Architekturen aufbauen, verwundbar macht.

Die vielfachen Architektur- und Strategiewechsel von Windows® erschweren die Entwicklungsarbeit immer mehr, was die Kosten zunehmend steigert und die langfristige Unterstützung von Industrie- und Prozesssteuerungsanwendungen gefährdet.

Als Automations- und System-Ingenieur habe ich Microsoft Windows® nie als eine zuverlässige Industrieplattform betrachtet: erstens wegen der bedenklichen Transparenz dieser Plattform, zweitens wegen des unangemessenen "Echtzeit"-Verhaltens (dabei bedeutet "Echtzeit" mindestens ein deterministisches zeitliches Verhalten und ein präzises und monotones Zeitmanagement) und drittens wegen den begrenzten Möglichkeiten für eine langfristige Entwicklungsstrategie.

Zurück zu POSIX-Standard und offenen (und Echtzeit-) Plattformen

Wenn eine vernünftige und zuverlässige Betriebssystem- Alternative für langfristige Zwecke gesucht werden muss, ist die Wahl sowohl begrenzt als auch sehr umfangreich:

- Begrenzt, weil heute die einzige Alternative *nix basierende Systeme sind, insbesondere GNU/Linux und seine eingebettete Variante eLinux, sowie VxWorks oder QNX für echte Echtzeit-Anwendungen.

- Umfangreich, weil zahlreiche Varianten von Linux sowohl für Betriebssystem-Kernel als auch für Benutzeroberflächen (sogenannte "Desktop-Umgebung") verfügbar sind.

Das Ziel ist hier nicht, eine besondere GNU/Linux-Distribution zu befürworten, sondern zu zeigen, dass eine reale Welt neben Microsoft Windows® existiert und dass solche Betriebssysteme Investitionen und Entwicklungskosten wegen ihrer Offenheit und langfristigen Zuverlässigkeit sichern können.

Der beste Weg, um die Portabilität von Anwendungen zu sichern, ist, sich auf weitgehend akzeptierte und unterstützte Standards zu verlassen. POSIX - Portable Operating System Interface - ist einer dieser Standards, der in den späten 1980er und frühen 1990er erarbeitet wurde, um eine "sanfte" und zuverlässige Portabilität von entwickelten Anwendungen zwischen verschiedenen Betriebssystemen und Betriebssystemversionen zu gewährleisten.

Zusammen mit einer geeigneten Entwicklungsumgebung (einschließlich portierbare und offene Programmiersprachen) und mit sauberen und robusten Softwareentwicklungspraktiken stellt POSIX eine stabile und portierbare Softwareentwicklungsplattform zur Verfügung.

Selbst wenn der Linux-Kernel im Laufe der Jahre neue Entwicklungen und signifikante Veränderungen erlebt hat, sind gut entwickelte Software-Anwendungen dennoch auf den neuesten Linux-Plattformen mit limitierten Aufwand portierbar, was eine langfristige Unterstützung sichert.

Plattform-unabhängige Benutzerschnittstellen

Prinzipiell stehen zwei Ansätze zur Verfügung, um Applikationsbenutzerschnittstellen zu entwickeln und zu implementieren:

- Web-basierte Benutzerschnittstellen

- Multiplattformfähige Benutzerschnittstellen auf Basis von Applikations-Frameworks.

W3C-konforme web-basierte Benutzerschnittstellen

In den letzten 20 Jahren haben web-basierte Benutzerschnittstellen immer mehr sogenannte "fat client"-Applikationen - d.h. spezifisch für Anlagen, Geräte und Serveranwendungen entwickelte Applikationen - effizient ersetzt.

Durch web-basierte Benutzerschnittstellen können Equipment-Lieferanten die Entwicklung von "fat-client"- Applikationen für die Bedienung von Anlagen bzw. Geräten vermeiden und sich dabei die notwendigen Entwicklungs- und Wartungsaufwände für jeden Betriebssystemtyp und jede -version sparen. Ein solches Vorgehen stellt eine reale und effiziente Verbesserung der langfristigen Unterstützung und der Sicherheit dar. Dennoch erfordert ein solches Design eine akkurate Implementierung der W3C-Spezifikationen, um die W3C-Standards lückenlos zu unterstützen und um einen neutralen und konsistenten Betrieb von Webbrowsern7 mit einem hohen Kompatibilitätsgrad zu sichern. Es ist insbesondere äußerst wichtig, nicht auf proprietäre Webbrowser- Technologien zu fokussieren, sondern eher nicht-proprietäre Standards vorzuziehen.

Qt-basierte Benutzerschnittstellen - Portierbarkeit bei Design

Ursprünglich 1995 vom norwegischen Software-Unternehmen Trolltech AS eingeführt, ist Qt heute ein weitverbreitetes plattformübergreifendes Applikations- Framework, um Anwendungen für verschiedene Plattformen und graphische Benutzerschnittstellen (GUIs) zu entwickeln. Viele Firmen (einschließlich "Global Players") in verschiedenen Bereichen - Automotive, medizinische Geräte, Unterhaltungselektronik, Mobilgeräte - haben Qt übernommen. Es ist eine zuverlässige und stabile Entwicklungsplattform, die Entwicklungsaufwände beschränkt, die Portierbarkeit von Applikationen gewährleistet sowie die Entwicklungen und die Investitionen langfristig sicherstellt. Qt steht sowohl als kommerzielle als auch als Open Source GPL-Lizenz zur Verfügung. Es unterstützt standardmäßig verschiedene Betriebssystem-Plattformen wie embedded Linux (eLinux), VxWorks, QNX, sowie Linux, macOS® und Windows® für Desktop-Umgebungen genauso wie mobile Plattformen wie Android und iOS.

Qt kann gleichermaßen für die Entwicklung von webbasierten Benutzerschnittstellen auf Basis von HMTL5, Hybrid-Benutzeroberflächen sowie nativen widget-basierten Benutzerschnittstellen verwendet werden.

Robustes IT-Infrastruktur-Design

Die heutige Herausforderung der Industrie besteht in der Aufrechterhaltung ihres Geschäftsbetriebes und ihrer Leistungsfähigkeit. Ohne eine funktionsfähige IT-Infrastruktur könnten dabei heute nur sehr wenige Firmen überleben. Und im Katastrophenfall haben schwerwiegende Datenverluste gravierende Auswirkungen auf die Zukunft einer Firma bzw. gefährden sie sogar. Weniger als 10% der Unternehmen überleben einen vollständigen Datenverlust8.

Eine robuste IT-Infrastruktur zu gestalten, ist zunächst weniger eine GxP-Anforderung als vielmehr eine einfache, jedoch lebenswichtige Betriebsanforderung. Der Aufwand zur Aufrechterhaltung einer IT-Infrastruktur ist eine Investition mit direktem Einfluss auf die Leistungsfähigkeit des Unternehmens. Die Frage ist nicht "ob", sondern "wann" eine Attacke erfolgen wird. Es sollte auch deutlich werden, dass die IT-Sicherheit einem Krieg ähnelt, in dem man nur einzelne Kämpfe, aber nie den Krieg gewinnen kann.

Im Abschnitt zum IT-Infrastrukturdesign wurden bereits einige Empfehlungen gegeben. Dazu sollte die Infrastruktur von gut ausgebildeten und gut geschulten Systemadministratoren unterstützt werden. Es ist notwendig, für die Auslegung der IT-Infrastruktur einen sehr defensiven Ansatz zu wählen sowie zuverlässige und genaue Überwachungs- und Betriebsstrategien zu erarbeiten. Die Zuverlässigkeit und die Sicherheit der IT Infrastruktur sind nicht selbstverständlich, sondern resultieren aus einer systematischen und defensiven Vorgehensweise.

Selbst wenn IT-Sicherheit-Maßnahmen dazu führen, dass die betriebliche Flexibilität manchmal etwas abzunehmen scheint, sollte klar sein, dass die IT-Sicherheit nicht verhandelbar sein kann (selbst für die Geschäftsleitung nicht).

Die Robustheit der IT-Infrastruktur ist nur durch die Implementierung eines defensiven Designs mit einer starken Trennung der verschiedenen Netzwerke, durch den Aufbau von zuverlässigen und geprüften Redundanzen sowie durch akkurate Betriebsprozesse erreichbar. Zum Beispiel muss ein spezifisches und gesichertes Netzwerk zur Verwaltung von aktiven IT-Infrastruktur-Komponenten und zur Aufschaltung von Server-Konsolen verfügbar sein. Ansonsten wird es im Fall von Sicherheitsverletzungen für einen "Cracker" sehr einfach (und effizient) sein, die Konfiguration von Speichernetzwerken (SANs und deren Fibre Channel Fabrics) zu verändern, was zu einem sofortigen und sehr wahrscheinlich unwiderruflichen Datenverlust führen wird.

Die verfügbare Zeit, um Sicherheits-Patches zu beurteilen und um die Veränderungen einzuschätzen, hängt direkt von der Robustheit der IT-Infrastruktur ab.

Fazit

Die Industrie ist derzeit mit vielseitigen und ernsten IT-Bedrohungen9 konfrontiert, die im Stande sind, die Leistungsfähigkeit eines Unternehmens zu gefährden oder es gar zu zerstören.

Wir müssen eingestehen, dass diese Situation das Ergebnis von Entscheidungen ist, die hinsichtlich Geschäftsfähigkeit und IT-Sicherheit vor Jahren mit unzureichender Sorgfalt getroffen wurden. Die Technologie, die Designlösungen und die Empfehlungen, eine robuste IT-Infrastruktur und sichere Prozesssteuerungen und Leitsysteme zu entwerfen, sind seit mehr als 25 Jahren verfügbar (siehe z.B. POSIX, VxWorks, QNX), einschließlich portabler Benutzerschnittstellen (z.B. webbasiert oder auf Basis von Qt).

Die regulierte Industrie und ihre Anlagen- und Geräte- Lieferanten müssen aktiv zusammenarbeiten, um den Aufbau von besseren Steuerungssystemen sowie für Labor- und Produktionsanlagen als auch für die Prozessautomation zu unterstützen. Die notwendigen teuren Investitionen für neue Anlagen und Geräte ist nicht mehr mit dem kurzfristigen Support (von nur wenigen Jahren) auf Windows® - Ebene10 zu vereinbaren.

Dennoch ist es dringend, einen solchen Paradigmenwechsel einzuleiten. Denn Architekturveränderungen nehmen einige Jahre in Anspruch, bis Produktions- und Infrastrukturanlagen sowie analytische Geräte auf Basis einer solchen zuverlässigeren Softwarearchitektur auf dem Markt verfügbar sind.

Entsprechende Anforderungen müssen durch regulierte Kunden für die langfristige Unterstützung und die langfristige Verfügbarkeit und Lesbarkeit der Daten festgelegt und geltend gemacht werden. Diese Anforderungen müssen von den Lieferanten (prospektiv) berücksichtigt werden.

Im Rahmen der Datenintegrität und der erforderlichen Nachrüstung der Systeme wäre es sinnvoll, gleichermaßen Anforderungen für die langfristige Systemverfügbarkeit wahrzunehmen. Solche Strategiewechsel sind für Lieferanten hinsichtlich Schulung und Design wirklich anspruchsvoll: neue Entwicklungsplattformen, neue Entwicklungsumgebung, wahrscheinlich verschiedene Programmiersprachen. Aber wenn die "Industrie 4.0" eine effektive und effiziente Realität werden soll, sind solche Paradigmenwechsel unvermeidbar.

Im Jahr 2016 waren bereits die ersten nennenswerten Probleme, verursacht durch ungeeignetes Design und grob fahrlässige Implementierung von "Internet der Dinge"-Geräte, schon weltweit spürbar.

Jetzt ist es an der Zeit, die IT-Landschaft und das Design von computergestützten Industriesystemen und -anlagen zu überdenken und dabei zuverlässigere und zukunftssichere Systemarchitekturen zu fordern.

Nachwort

Seit dem ersten Entwurf dieses Artikels im Mai 2017 gab es neue Cyberattacken (siehe "Petya" bzw. "NotPetya", "GoldenEye"), die zahlreiche Organisationen (z.B. das britische NHS) - einschließlich größere Firmen (z.B. Renault, Maersk, Saint-Gobain, TNT Express (FedEx)) und global agierende pharmazeutische Unternehmen (z.B. MSD, Reckitt Benckiser) - betreff en. Zirka fünf Wochen nach den ersten "WannaCry"-Attacken wurden größere Produktionsanlagen (z.B. Honda) von "WannaCry Nachwehen" bis zur Betriebsunfähigkeit betroffen.

Seminarempfehlung

26-28 November 2025

Computerised System Validation: The GAMP 5 Approach - Live Online Training

Ähnlich wie "WannaCry" nutzen die jüngsten Schadprogramme und Schadwürme Schwächen von Vorgängerversionen von Windows® Betriebssystemen und Netzwerkdiensten (z.B. SMB). Und die Bemerkungen bezüglich der eigenen Update-Strategien haben sich nach wie vor nicht geändert und ignorieren weiterhin die Komplexität von Industrie- und Echtzeit-Systemen und der damit verbundenen Einschränkungen.

Die Industrie sollte sich darauf einstellen, dass solche Angriffe in Zukunft sicher Bestandteil des täglichen Geschäfts werden.

Es ist offensichtlich, dass ein solcher Cyberkrieg nicht zu gewinnen ist; nur einzelne Kämpfe können vorübergehend gewonnen werden, die niemals zukünftige Erfolge voraussetzen.

Autor:

Yves Samson

... ist Gründer und Direktor des Consulting- Unternehmens Kereon in Basel. Er hat über 25 Jahre Erfahrung in der Qualifizierung und Validierung von GxP Computersystemen und von IT-Infrastruktur. Er ist außerdem Editor der französischen Version des GAMP®4 und GAMP®5. Mit der im März 2017 gestarteten e-Compliance Requirements Initiative - ecri.kereon.ch - will er die regulierte pharmazeutische Industrie und deren Lieferanten bei der akkuraten und effizienten Implementierung und Erfüllung von e-Compliance- Anforderungen unterstützen.

Fußnoten:

1 In der Zwischenzeit - Ende Juni 2017 - haben Attacken auf Basis von (Not)Petya und GoldenEye verschiedenen Organisationen - einschließlich sogenannten "Global Players" - schwere Schäden zugefügt.

2 Siehe http://www.ubergizmo.com/2017/05/wannacry-victims-mostly-running-windows-7/

3 OLE: Object Linking and Embedding

4 Siehe: Get Windows 10 "update"

5 https://support.microsoft.com/en-US/help/4012982/the-processor-is-not-supported-together-with-the-windows-version-that

6 In der Zwischenzeit wurde die Situation noch verworrener, da diese Einschränkung- mindestens vorübergehend - scheinbar zurückgenommen wurde. Aufgrund einer fehlenden klaren Aussage von Microsoft zu dieser Einschränkung ist es für die Industrie wirklich schwierig, zuverlässige Support-Pläne zu erarbeiten.

7 Nicht-standard-konforme Implementierungen auf Basis von Chrome oder Edge gefährden die langfristige Unterstützung von web-basierten Benutzerschnittstellen. Eine strikte Konformität mit dem W3C-Standard, auf Basis von HTML5, würde die Lebensdauer der Benutzerschnittstelle sichern. Firefox und Vivaldi könnten für die Durchführung der Funktionstests (OQ) von solchen Benutzerschnittstellen sinnvoll eingesetzt werden.

8 Gemäß einer Untersuchung von Touche Ross.

9 Selbst aktualisierte Antivirus-Software sind nicht in der Lage, Ransomware zuverlässig zu erkennen.

10 Siehe http://www.zdnet.com/article/windows-as-a-service-means-big-painful-changes-for-it-pros/